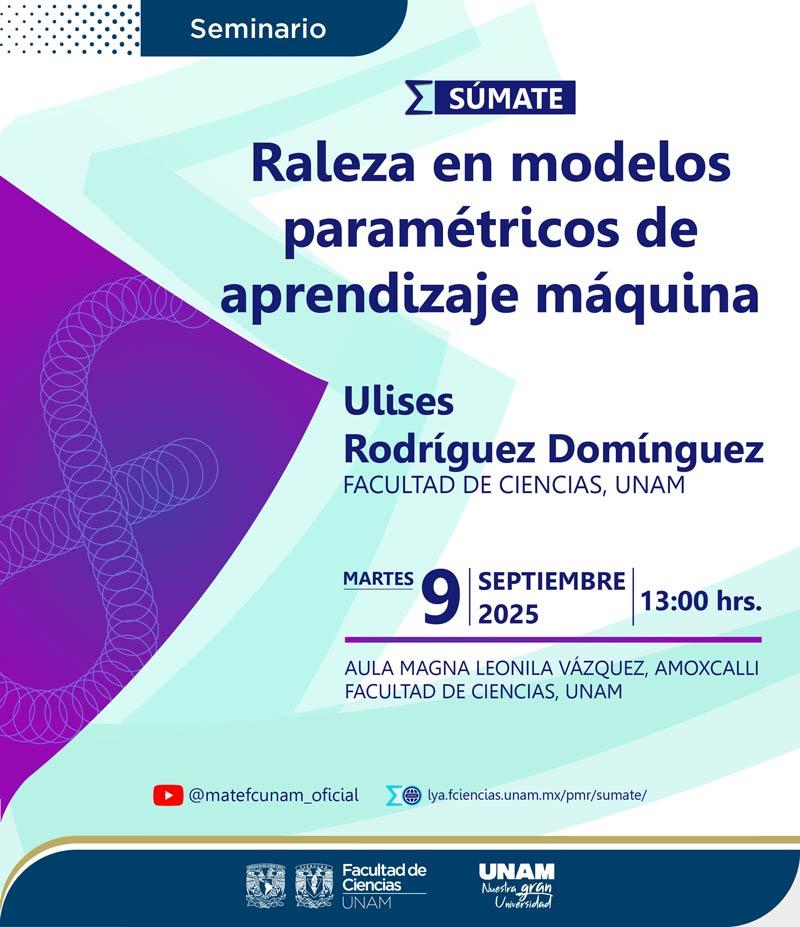

Raleza en modelos paramétricos de aprendizaje maquina

Seminario Súmate

Ulises Rodríguez Domínguez

- Facultad de Ciencias, UNAM.

09 SEP 2025

13:00 h.

Aula Magna Leonila Vázquez

Transmisión: @matefcunam_oficial

Los modelos paramétricos de aprendizaje máquina están sujetos a cometer errores de predicción para nuevas observaciones dependiendo del balance entre el sesgo y la varianza que estos logren después de ser entrenados. Una manera de ayudar a controlar este balance es mediante técnicas de regularización, las cuales permiten restringir de distintas maneras las soluciones que se pueden aprender para los parámetros. La regularización rala es un tipo particular de regularización que impone o promueve raleza en las soluciones para los parámetros. Otra manera de imponer raleza es ajustando el modelo de una distribución rala a un conjunto de datos. En esta plática abordaremos ambas maneras de imponer raleza en modelos de aprendizaje máquina y veremos ejemplos de aplicación en: aprendizaje profundo y en el modelado de la actividad poblacional de neuronas binarias.

Informes: rpm@ciencias.unam.mx